Kaito

Aktives Mitglied

Thread Starter

- Dabei seit

- 31.12.2005

- Beiträge

- 7.093

- Reaktionspunkte

- 1.844

Hallo,

vorweg: ich bin nicht sicher, ob ich hier richtig bin.

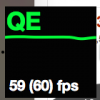

Wenn ich in Systemeinstellungen -> Display sehe, dann werden mir bei meinem hier angeschlossenen Dell u2312 "60Hz" angeboten.

Was versteht OSX hierunter? Handelt es sich um 60Hz, oder sind es 60000/1001?

Ich hab mir mal die EDID des Monitors ausgegeben und mit Wiki und einem Hexeditor durchgeschaut, aber nicht nur sehen die dortigen vorbestimmten Profile gar keine 60000/1001Hz (sondern nur "60") vor, auch die detaillierten Timings haben gar nicht die notwendige Bitzahl um so eine Zahl wie 60000/1001 zu repräsentieren. Gleichzeitig aber gibt es definitiv (Computer)Displays die mit 60000/1001Hz laufen.

Was läuft schief? Was verstehe ich schief?

Ich habe gelesen, dass Windows diese Zahl auf 60Hz aufrundet (bzw. abrundet, auf 59). Macht OSX das auch?

vorweg: ich bin nicht sicher, ob ich hier richtig bin.

Wenn ich in Systemeinstellungen -> Display sehe, dann werden mir bei meinem hier angeschlossenen Dell u2312 "60Hz" angeboten.

Was versteht OSX hierunter? Handelt es sich um 60Hz, oder sind es 60000/1001?

Ich hab mir mal die EDID des Monitors ausgegeben und mit Wiki und einem Hexeditor durchgeschaut, aber nicht nur sehen die dortigen vorbestimmten Profile gar keine 60000/1001Hz (sondern nur "60") vor, auch die detaillierten Timings haben gar nicht die notwendige Bitzahl um so eine Zahl wie 60000/1001 zu repräsentieren. Gleichzeitig aber gibt es definitiv (Computer)Displays die mit 60000/1001Hz laufen.

Ich habe gelesen, dass Windows diese Zahl auf 60Hz aufrundet (bzw. abrundet, auf 59). Macht OSX das auch?

Zuletzt bearbeitet: