Amiks

Aktives Mitglied

Thread Starter

- Dabei seit

- 06.01.2013

- Beiträge

- 256

- Reaktionspunkte

- 8

Liebe Community,

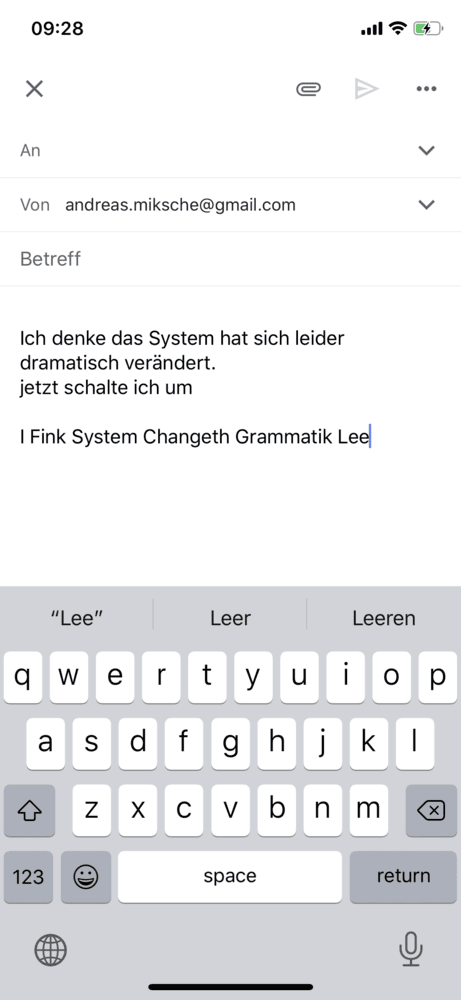

habe das Gefühl, dass die Diktierfunktion auf meinem iPhone X nach den letzten updates immer schlechter geworden ist. Besonders wenn ich die Sprachen umstelle kommt dann leider ein unzusammenhängender Kauderwelsch, den man nicht einmal als "denglisch" bezeichnen kann heraus.

Das Ergebnis meines englisch-gesprochenen Textes ergibt doch keinen sinnvollen zusammenhängenden Text. Und es heißt doch bei Apple "Möglicherweise missverstandene Wörter werden blau unterstrichen, damit Sie leichter prüfen können, ob diese korrekt transkribiert wurden". Also nicht einmal das passiert bei mir - jetzt nehme ich an, dass es am System liegen könnte.

Habe deshalb einen Screenshot von meinem letzten Diktat angehängt. Jetzt meine Frage - hat hier schon jemand ähnliche Erfahrungen gemacht? Gibt es eine Lösung - update der Diktierfunktion oder ähnliches (begebe mich jetzt in Gefahr, dass ich ein blöde Frage gestellt habe - ich weiß). Da ich viel mit dieser Funktion arbeiten muss und es früher (nach welchem update es das erste mal aufgetreten ist weiß ich leider nicht mehr) problemlos funktioniert hat wäre ich über konstruktive Lösungsvorschläge sehr dankbar.

Amiks

habe das Gefühl, dass die Diktierfunktion auf meinem iPhone X nach den letzten updates immer schlechter geworden ist. Besonders wenn ich die Sprachen umstelle kommt dann leider ein unzusammenhängender Kauderwelsch, den man nicht einmal als "denglisch" bezeichnen kann heraus.

Das Ergebnis meines englisch-gesprochenen Textes ergibt doch keinen sinnvollen zusammenhängenden Text. Und es heißt doch bei Apple "Möglicherweise missverstandene Wörter werden blau unterstrichen, damit Sie leichter prüfen können, ob diese korrekt transkribiert wurden". Also nicht einmal das passiert bei mir - jetzt nehme ich an, dass es am System liegen könnte.

Habe deshalb einen Screenshot von meinem letzten Diktat angehängt. Jetzt meine Frage - hat hier schon jemand ähnliche Erfahrungen gemacht? Gibt es eine Lösung - update der Diktierfunktion oder ähnliches (begebe mich jetzt in Gefahr, dass ich ein blöde Frage gestellt habe - ich weiß). Da ich viel mit dieser Funktion arbeiten muss und es früher (nach welchem update es das erste mal aufgetreten ist weiß ich leider nicht mehr) problemlos funktioniert hat wäre ich über konstruktive Lösungsvorschläge sehr dankbar.

Amiks